华中科技大学白翔团队联合华南理工大学、阿德莱德大学和字节跳动推出新一代 OCR 评测基准 OCRBench v2,分别从中文和英语两个语种上,对 2023 年至 2025 年间全球 58 个主流多模态大模型进行了测评。

过去几十年间,光学字符识别(OCR, Optical Character Recognition) 技术的定位与价值经历了从传统图像识别工具到智能信息系统核心能力的巨大演进,最初,其主要是将印刷体或手写文字从图像中提取并转换为可被计算机理解的文本数据。如今,随着深度学习和多模态模型的发展,丰富需求的驱动下,OCR 的技术边界也在不断扩展,它不仅要识别字符,更要理解文档的结构与语义——在复杂场景中准确解析表格、版面、图文混排内容。

更进一步地,在大规模多模态预训练中,模型接触到海量包含文字的图像数据,如网页截图、UI 界面、海报、文档等,OCR 能力因此在无监督学习过程中自然涌现。这使得大模型不再依赖外部 OCR 模块,而是能直接在端到端的推理过程中完成识别、理解和回答。更重要的是,OCR 技术正成为上层智能任务的前提条件——只有当模型能准确识别图像中的文本,它才能进一步完成图表解析、文档问答、知识抽取甚至代码理解。

可以说,在 OCR 任务中的表现也是评价多模态大模型能力的重要指标之一,并且当下的需求早已超越了「读出文字」,文档中的表格、图表、手写笔记、复杂的版式,文字图像的文本定位,以及基于文本的推理等等,都是模型需要攻克的难关。而传统的 OCR 评测基准大多任务单一、场景有限,导致模型得分迅速饱和,难以真实反映其在复杂应用中的能力。

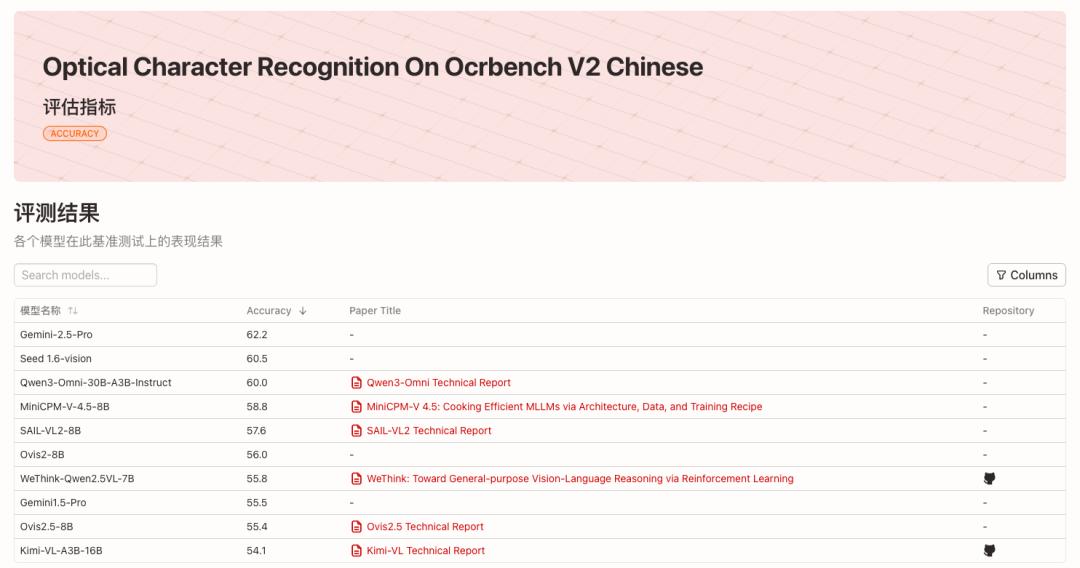

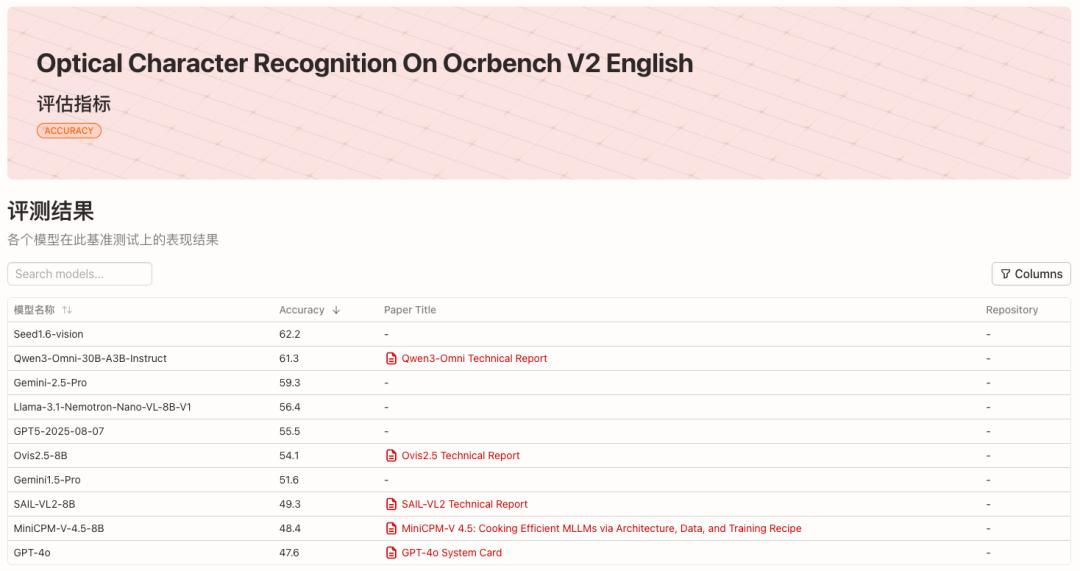

针对于此,华中科技大学白翔团队联合华南理工大学、阿德莱德大学和字节跳动推出新一代 OCR 评测基准 OCRBench v2,分别从中文和英语两个语种上,对 2023 年至 2025 年间全球 58 个主流多模态大模型进行了测评,各榜单得分前 10 名的模型如下图所示:

OCRBench v2 中文榜单

OCRBench v2 英文榜单

* 查看英文榜单:https://go.hyper.ai/wlGTR

* 查看中文榜单:https://go.hyper.ai/HZenn

* 项目开源地址:https://github.com/Yuliang-Liu/MultimodalOCR

23 种细分任务,覆盖多样化场景

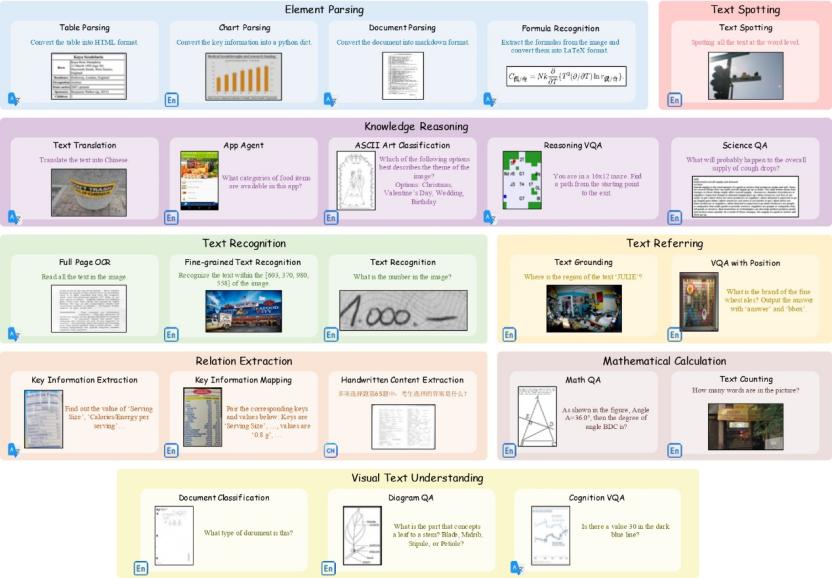

OCRBench v2 涵盖了 23 种细分任务,覆盖 8 大核心能力维度——文本识别、文本定位、文本检测识别、关系抽取、元素解析、数学计算、视觉文本理解和知识推理。

OCRBench v2 涵盖任务的典型样例

OCRBench v2 的公开数据集包含来自 80 余个学术数据集及部分自有数据的 1 万条高质量 QA,并经过人工审核,确保覆盖真实 OCR 应用中的多样化场景。此外,OCRBench v2 还包括了独立的私有数据,这部分数据包含人工采集并标注的 1,500 条 QA,其任务设置和场景覆盖范围均与公开数据保持一致。

* 数据集下载地址:https://go.hyper.ai/VNHSX

团队实验发现,公开数据与私有数据榜单排名具有较高的一致性,这证明了 OCRBench v2 任务设计、数据构造和评价指标的合理性,体现了其在衡量多模态大模型现有局限方面的重要价值。

相关研究论文以「OCRBench v2: An Improved Benchmark for Evaluating Large Multimodal Models on Visual Text Localization and Reasoning」为题,已收录于 NeurIPS 2025(Datasets and Benchmarks Track)。

* 论文地址:https://go.hyper.ai/VNHSX

主流模型普遍偏科,最高得分仅及格

在 OCRBench v2 最新发布的评测榜单中,Gemini-2.5-Pro 获得了中文榜单的冠军、英文榜单季军,Seed1.6-vision 则是获英文榜冠军、中文榜亚军。在开源阵营中,Qwen3-Omni-30B-A3B-Instruct 分别取得英文榜第二名和中文榜第三名的佳绩。

通过分析模型的各项核心能力表现可以发现,这些多模态大模型普遍存在「偏科」现象,鲜有模型能在所有核心能力上都表现出色,即便是排名靠前的模型,在英文和中文任务中的平均分也仅约为 60 分(满分 100)。此外,各个模型的擅长方面也略有不同,例如 Gemini-2.5-Pro 等商用模型在计算类题目上,具有明显优势,展示出其强大逻辑推理能力;Llama-3.1-Nemotron-Nano-VL-8B-V1 则凭借其强大的文字定位能力,取得英文榜单第四名的成绩。

而大多数模型在基础的文本识别上表现尚可,但在文本定位(Referring)、文本检测识别(Spotting)和元素解析(Parsing)等对细粒度空间感知与结构化理解要求高的任务上,得分普遍偏低。例如,即使是榜单冠军 Seed1.6-vision,在 Spotting 得分也仅为 38.0,这也限制了其在场景文字、图文混杂文档等真实场景下的应用效果。

此外,通过对比中英文榜单,可以发现许多模型的多语言能力并不均衡。例如 Llama-3.1-Nemotron-Nano-VL-8B-V1 在英文榜单上高居第四名(平均分 56.4),但在中文榜单上仅排第 31 名(平均分 40.1),显示其在英文场景更具优势,这可能与数据分布或训练策略相关。

与此同时,尽管闭源模型保持领先,但优秀开源模型已具备强大竞争力。从榜单来看,Gemini 系列、GPT5、Seed1.6-vision 等闭源模型的整体性能更胜一筹,但 Qwen-Omni、InternVL、SAIL-VL、Ovis 等系列的开源模型已具备强劲竞争力,英文榜单前 10 的模型中有 5 个为开源模型,而中文榜单前 10 的模型中,有 7 个为开源模型。开源模型在诸如文字定位、元素提取、视觉文字理解等类型任务上也能够达到顶尖水平。

OCRBench v2 榜单将按季度更新,HyperAI 也将持续追踪最新的评测结果。